來源:澤平宏觀

12月10日,谷歌公布最新一代量子芯片——Willow,轟動全球科技界,連馬斯克都驚嘆一聲“哇塞” !

Willow芯片強大在哪?距離大規模量產還有多遠?

1. 谷歌最新一代量子芯片Willow炸裂推出,最大的突破在於超強的計算能力和糾錯能力

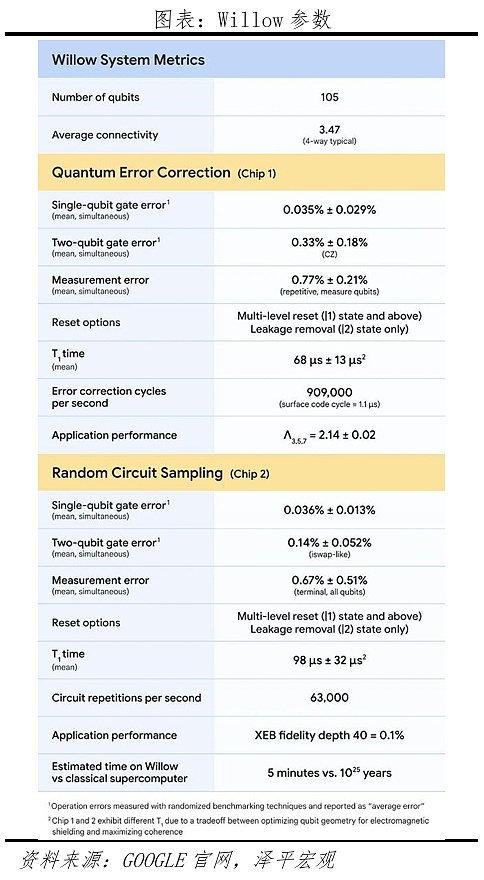

對於一項名爲“隨機電路採樣”的基准任務,當前最快的超級計算機需要花費10 的 25 次方年來解決,時長遠超宇宙年齡(267億年);而Willow完成這項任務的時間不到5分鐘。

量子計算有潛力在特定任務上顯著提高計算速度、超越經典計算機,這被稱爲“量子優越性”。早在2019年,谷歌就已經驗證了這一事實,在《Nature》公布,表明其利用一台 54量子比特的量子計算機Sycamore實現了傳統架構計算機無法完成的任務:在世界第一超級計算機需要計算1萬年的某實驗中,Sycamore只用了3分20秒。彼時谷歌CEO桑達爾·皮查伊表示這是研究者期待已久的一句“Hello World”,是截至當時,量子計算實用化最有意義的一個裏程碑。

此次Willow的發布,無疑是量子計算領域的又一標志性事件。

然而,“快”還並不是Willow最值得矚目的突破。

Willow最大亮點在於超強糾錯能力。

過去,量子芯片在數據處理過程中,由於量子態的脆弱性,容易受到環境幹擾而發生退相幹現象,導致量子比特的狀態出錯。所以,盡管具備“量子優越性”,但量子計算機容易受到環境影響,非常容易出錯。通常,量子比特越多,發生的錯誤就越多。

因此,“量子糾錯”就成了一項關鍵技術,量子芯片需要特殊的量子糾錯技術,這也是該領域的重要挑战,也一度嚴重制約了量子計算的實際應用和發展。

Willow 芯片成功解決了近 30 年來一直困擾研究者的量子糾錯難題,實現了錯誤率的指數級降低。谷歌的研究表明,在Willow中使用的量子比特越多,系統的錯誤率越低。

當量子比特數量增多,從 3×3 的陣列擴展到 5×5 再到 7×7 的陣列時,谷歌的 Willow 芯片實驗中每次擴展都能將編碼錯誤率降低 2.14 倍,錯誤率下降得越來越快。

2.什么是量子計算?爲何如此強大?

1935年,奧地利物理學家薛定諤提出一個偉大的思想實驗:把貓裝在一個放有放射性物質的盒子裏,有50%的概率放射性物質會衰變並釋放出毒氣殺死這只貓,同時有50%的概率放射性物質不會衰變而貓將活下來。在打开盒子前,誰也不知道貓活着還是死了,只能用“處於生死疊加態”來描述。

量子世界,就如同“薛定諤的貓”一樣,處於一種懸而未決的疊加態;對應的新計算理論即爲“量子計算”,硬件層則表現爲量子芯片、量子計算機。

量子計算表現出兩個優點:

第一,強大的數據存儲能力。經典計算以比特爲基本單元,而量子計算以量子比特爲基本單元。

在經典計算中,比特的狀態是確定的,要么是0要么是1;而量子比特卻處於0和1的疊加態,換句話講,它可以同時存儲0和1。

1塊有n個比特的傳統芯片,可以同時存儲n個數據;而一塊擁有n個量子比特的芯片,則能夠在同一時刻存儲2^n個數據。

第二,對特定問題展現出強大的並行運算能力。

傳統電子計算機是串行計算,每次操作只能將單一數值轉換爲另一個數值,這意味着它必須依照順序進行計算。而量子計算機通過一次操作即可同時將2^n個數據轉換爲新的2^n個數據。

3.未來的量子芯片能否替代GPU,推動AI發展進程?

人工智能技術及各種應用在最近幾年飛速發展,對計算能力的需求也指數級增長。

理論上講,量子計算的並行處理能力,使其在處理復雜的人工智能算法時具有天然的優勢,能夠大大提高模型的訓練速度和准確性。Willow芯片的出現,或許能夠爲人工智能的進一步發展提供了強大的算力开拓。

其實,現在被廣泛應用於AI的GPU,最初也是爲了加速圖形處理而設計。比如遊戲中的3D 場景渲染、動畫制作中的建模和特效處理、影視制作中的視頻視覺效果等。但是,由於其強大計算能力,GPU後來才被廣泛應用於科學計算和人工智能領域,特別是深度學習中的神經網絡訓練和推理階段,在處理大規模數據集、並行度高的計算任務時表現出色。

從這個角度看,量子芯片未來也會逐步突破發展,打破計算限制,加速各類AI機器學習算法的訓練過程。量子芯片目前主要應用於一些對計算復雜度要求極高的特定領域,如密碼學中的加密算法破解(例如對基於 RSA 算法的傳統加密方式構成潛在威脅)、量子系統模擬(模擬分子、材料等量子層面的物理和化學性質)、復雜的優化問題求解(如物流規劃、資源分配等復雜的組合優化問題)等。在這些領域,量子計算的優勢能夠得到充分發揮,有可能解決傳統計算機在可接受時間內無法完成的任務。

量子芯片計算能力的增長主要與量子比特數量的增加和質量的提升相關。未來,隨着量子比特數量的增多,量子計算機的計算能力呈指數級增長。每增加一個量子比特,其可能的狀態組合數就會翻倍。例如,2 個量子比特有 4 種狀態組合,3 個量子比特有 8 種狀態組合,以此類推。同時,量子比特的質量(如相幹時間、保真度等)也對計算能力有重要影響,高質量的量子比特能夠更有效地保持量子態,從而實現更准確、更復雜的計算。

但是,從短期來看,量子芯片難以撼動GPU的地位。量子芯片相比GPU擁有更強的計算能力,理論上可以進行替代。但GPU的護城河,計算能力只是一方面,更重要的是:可編程架構和开發者生態優勢、制造工藝和產業成熟度。

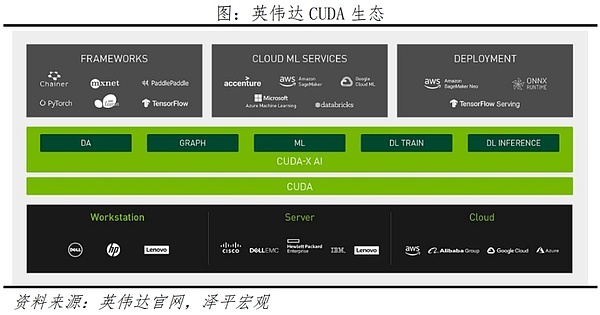

GPU的可編程架構和开發者生態是核心壁壘。英偉達用GPU掀起的這場“AI算力革命”鋪墊了十多年。

CUDA(Compute Unified Device Architecture)是2006年由英偉達开發的首個GPU編程架構平台,其價值在於構建了一個GPU开發者生態,算法工程師可以按照自己需求對GPU的能力進行發掘,這也將GPU的應用領域從圖形渲染拓展到了通用領域。

如果基於新的硬件(如量子芯片)开發新軟件,就需要實現向前兼容,但現有的主要AI軟件基本都依賴於CUDA平台开發,因此脫離CUDA架構需要付出高昂的成本。再加上开發社區的護城河效應,衆多高性能計算开發者是在CUDA生態中積累开發經驗的,CUDA每年有高達五百萬次的下載量,推動开發者社區轉向其他編程模型將是以十年計的工程。

GPU芯片制造工藝和產業鏈成熟,擁有廣闊的消費市場和產業正循環。

GPU從誕生至今已經25年,下遊的個人PC、定制开發、AI數據中心等商業化應用場景,已經形成10至30年不等。當前,GPU從芯片立項到流片一年,流片到量產一年,以GPU开發爲主基調,形成了光刻設備开發、晶圓代工工藝迭代等相應的聯動周期。如此的牢固產業鏈在十幾年的正循環下很難被打破。

而量子芯片制造和GPU產業鏈難以重疊。量子芯片的設計、制造工程極其復雜,需要高度純淨的實驗環境,精密的量子控制技術和穩定的量子比特,因此長期以來都是零星幾家頂尖科技公司在“單打獨鬥”,還沒有形成成熟的產業供應鏈。因此,短期內實現量子芯片的量產和商業化應用是一大難題。

4.量子芯片影響最大領域:加密貨幣和“HPC+AI”

4.1 量子芯片或是加密貨幣的“克星”

以比特幣爲例,其安全性建立在兩個關鍵機制之上。一是“挖礦”機制,比特幣產出基於依賴於哈希函數的工作量證明(Proof of Work),哈希率越高,挖礦成功的可能性也就越大。二是交易籤名,一種基於橢圓曲线數字籤名算法 (ECDSA),相當於用戶的“身份錢包”。這兩種機制的設計讓比特幣在傳統計算上幾乎無法被破解,而量子芯片將會對比特幣構成直接威脅。

一是量子計算對“挖礦”機制的暴力破解。量子計算的算法可以加速計算哈希函數,即加快挖礦速度,且幅度超過以往所有的傳統設備,結果是挖礦成功率提高,加密貨幣供應量驟增,造成其市場價格的大幅波動。12月10日,比特幣從10萬美元一度跌到9.4萬美元。Coinglass數據顯示,12月10日至12日共有23.7萬人爆倉。

二是量子計算對交易籤名的直接威脅。加密貨幣的交易存在“公鑰”和“私鑰”兩種憑證,前者相當於銀行卡號,後者相當於錢包密碼。通常,公鑰地址的公开並不會影響用戶的資金安全,但量子計算可以通過公鑰來破解籤名,並僞造交易。比如,量子計算中的Shor算法,專門用於破解大整數的質因數分解和離散對數問題,將對交易籤名造成嚴重威脅。

雖然Willow在當下對比特幣的威脅很小,但未來加密貨幣極有可能被量子計算突破。理論上,要對比特幣的籤名和挖礦機制發起攻擊,大約需要幾百萬個物理量子比特,這與Willow目前擁有的105個物理量子比特相比,差距仍然非常巨大。但如果Willow像通用GPU一樣迭代,實現量產和算力躍遷,那么未來十年比特幣被“攻陷”也不是不可能。

4.2 量子芯片將促進“HPC+AI”,推動高階人工智能發展

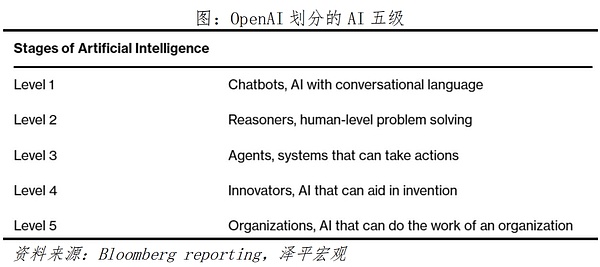

按照OpenAI對AI的分級,從L1(Chatbot)到L5(AGI),當前的AI大模型發展僅在L1到L2的過渡階段。L5級的AGI定義爲“具備組織級別能力”,對動態復雜的真實環境能進行判斷、推理、預測、並規劃行動。業界認爲“HPC+AI”將是實現AGI的關鍵一步。

高性能計算(HPC)指的是用強大的計算機能力來解決科學、工程和技術實現問題,和如今的AI大模型在一定程度上同源,但方向和側重點不同。

HPC側重於“復雜問題解決”,如超級計算機在氣象、物理、天文等領域的應用帶來過重大科研突破。

而AI模型側重於“推理和生成”,雖然不擅長於解決復雜模型,卻具備良好的通用性。

量子芯片的落地對HPC領域是革命性突破,復雜問題的解決不再需要傳統的HPC的長時間“暴力運算”,而是可以在新的方向發展——與AI結合進行更復雜的通用訓練。

一是傳統的AI訓練並不能對量子比特數據進行處理,而量子計算能優化特定的傳統計算無法處理的學習模型,並構建量子現象敏感的系統模型。即,未來的AI模型將具備推理、預測復雜世界的能力,相較於當前的大模型減少、甚至消除“AI幻覺”現象。

二是量子糾錯技術的優勢,Willow芯片克服了量子糾錯的關鍵挑战,實現了錯誤率的顯著降低。在高階AI訓練中,量子糾錯技術的應用能夠確保模型在訓練、處理大量復雜數據時的准確性和可靠性,減少因量子比特脆弱性導致的計算錯誤,從而提升AI訓練的效果和可信度。

雖然當前的AI訓練還不具備應用量子芯片的條件,但未來極有可能需要量子芯片作爲算力的核心支持。由於量子比特極爲敏感,容易受到外界環境因素的影響,包括溫度和電磁場等,這些因素可能導致量子態的退相幹,進而影響計算結果的精確度。盡管Willow在量子糾錯技術上取得了一定的進展,但在實際的人工智能訓練應用中,爲了實現長時間的穩定運行,量子系統的穩定性和抗幹擾性能仍需進一步提升。

谷歌發布新一代量子計算芯片Willow,在全球科技界引起了巨大的轟動,這不僅是量子計算領域的一項重大突破,也是下一個全球技術最前沿。

未來量子計算技術的發展之路仍有荊棘,距離大規模應用於 AI 訓練還有很多待解難題。

科技的進步從來都不是坦途,正如 GPU從默默無聞到大放異彩。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。