圖片來源:由生成

國內大模型技術競爭加速,繼訊飛星火、智譜推出最新產品之後,百川也迎來了新的大模型成果。

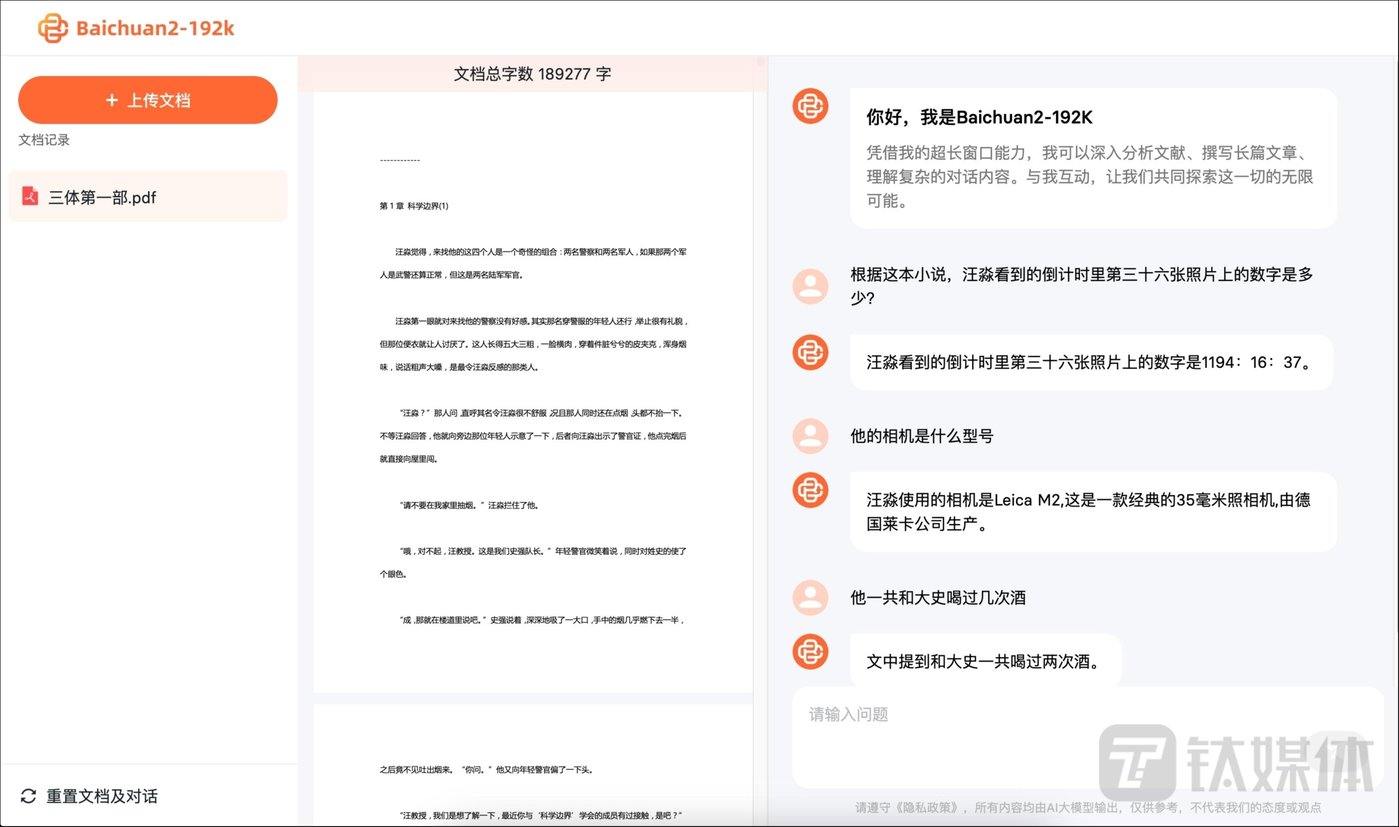

鈦媒體獲悉,10月30日上午,王小川創立的 AI 大模型公司“百川智能”宣布,推出Baichuan2-192K大模型,其上下文窗口長度高達192K,能夠處理約35萬個漢字。

百川智能稱,Baichuan2-192K是目前全球最長的上下文窗口,也是目前支持長上下文窗口最優秀大模型Claude2(支持100K上下文窗口,實測約8萬字)的4.4倍,更是GPT-4(支持32K上下文窗口,實測約 2.5萬字)的14倍(1400%)。這不僅在上下文窗口長度上超越Claude2,在長窗口文本生成質量、長上下文理解以及長文本問答、摘要等方面的表現也全面領先Claude2。

據悉,Baichuan2-192K將以API調用和私有化部署的方式提供給企業用戶。目前百川智能已經啓動該大模型的API內測,並开放給法律、媒體、金融等行業的核心合作夥伴。

據悉,百川智能成立於2023年4月10日,由搜狗公司創始人、前CEO王小川創立。其核心團隊由來自搜狗、Google、騰訊、百度、華爲、微軟、字節等知名科技公司的AI頂尖人才組成。目前,百川智能的團隊規模170余人,其中碩士及碩士以上學歷員工佔比近70%,研發人員佔比超80%。

過去200多天,百川智能平均每28天發布一款大模型,已連續Baichuan-7B/13B,Baichuan2-7B/13B四款开源可免費商用大模型及Baichuan-53B、Baichuan2-53B兩款閉源大模型,在寫作、文本創作等領域能力已達到行業較好水平。目前,Baichuan-7B/13B兩款开源大模型在多個權威評測榜單均名列前茅,累積下載量超過600萬次。

對於建立 AI 大模型公司,王小川曾表示,其團隊已有的技術工具可以用來建造大模型,公司的競爭對手就是大公司的开源方案。王小川還認爲,整個團隊不用太大,百人足夠。

8月31日,百川智能率先通過國家《生成式人工智能服務管理暫行辦法》備案,是首批八家公司中唯一一家今年成立的大模型初創公司,並於9月25日开放Baichuan2-53B API接口,正式進軍To B企業端領域,开啓商業化進程。

10月17日,百川智能宣布已完成A1輪3億美元的战略融資,阿裏、騰訊、小米等科技巨頭及多家頂級投資機構均參投了本輪。加上天使輪的5000萬美元,百川智能累計融資額已達3.5億美元(約合人民幣25.43億元)。

百川智能未透露當前具體估值,僅表示本輪融資後,公司躋身於科技獨角獸行列。根據一般定義,獨角獸估值超過10億美元(約合人民幣72.66億元)。

此次發布的Baichuan2-192K,百川智能表示在Dureader、NarrativeQA、LSHT、TriviaQA等10項中英文長文本問答、摘要的評測集上表現優異,有7項取得SOTA,顯著超過其他長窗口模型,全面領先Claude2。

百川方面指出,擴大上下文窗口能有效提升大模型性能是人工智能行業的共識,但是超長上下文窗口意味着更高的算力需求和更大的顯存壓力。目前,業內有很多提升上下文窗口長度的方式,包括滑動窗口、降採樣、小模型等。這些方式雖然能提升上下文窗口長度,但對模型性能均有不同程度的損害,換言之都是通過犧牲模型其他方面的性能來換取更長的上下文窗口。而本次百川發布的Baichuan2-192K通過算法和工程的優化,實現了窗口長度和模型性能之間的平衡,做到了窗口長度和模型性能的同步提升。

算法方面,百川智能提出了一種針對RoPE和ALiBi動態位置編碼的外推方案,在保證分辨率的同時增強了模型對長序列依賴的建模能力,而且當窗口長度擴大,Baichuan2-192K的序列建模能力持續增強;工程方面,在自主开發的分布式訓練框架基礎上,百川智能整合優化多個技術,獨創了一套全面的4D並行分布式方案,能夠根據模型具體的負載情況,自動尋找最適合的分布式策略,極大降低了長窗口訓練和推理過程中的顯存佔用。

Baichuan2-192K便能夠與更多的垂直場景深度結合,真正在人們的工作、生活、學習中發揮作用,助力行業用戶更好的降本增效。比如它可以幫助基金經理總結和解釋財務報表,分析公司的風險和機遇;幫助律師識別多個法律文件中的風險,審核合同和法律文件;幫助技術人員閱讀數百頁的开發文檔,並回答技術問題;還能幫助科員人員快速瀏覽大量論文,總結最新的前沿進展等。

目前,Baichuan2-192K以API調用的方式开放給百川智能的核心合作夥伴,已經與財經類媒體及律師事務所等機構達成了合作,稱不久後將全面开放。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。