作者:Hill Tan , Grace Deng;SevenX Ventures Research

對於我們這些生活在加密貨幣之下的人來說,人工智能已經火了一段時間。有趣的是,沒人想看到一個AI失控。區塊鏈被發明出來就是爲了防止美元失控,所以我們可能會嘗試一下。此外,我們現在有了一個新的叫做ZK的技術,它被用來確保事情不會出錯。我只是假設普通人對區塊鏈和ZK有一點了解。然而,爲了馴服AI這個野獸,我們必須理解AI是如何工作的。

第一部分:易懂的機器學習簡介 AI已經有了幾個名稱,從“專家系統”到“神經網絡”,然後是“圖形模型”,最後是“機器學習”。所有這些都是“AI”的子集,人們給它們不同的名字,我們對AI的了解也更深了。讓我們深入了解機器學習,揭开機器學習的神祕面紗。

注意:現今大多數的機器學習模型都是神經網絡,因爲它們在很多任務上的表現優秀。我們主要將機器學習稱爲神經網絡機器學習。

那么,機器學習是如何工作的呢?

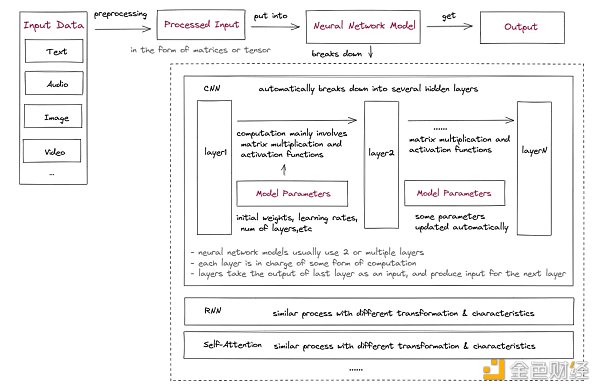

首先,讓我們快速了解一下機器學習的內部工作原理:

1 .輸入數據預處理:

輸入數據需要被處理成可以作爲模型輸入的格式。這通常涉及到預處理和特徵工程,以提取有用的信息,並將數據轉換成適當的形式,例如輸入矩陣或張量(高維矩陣)。這是專家系統的方法。隨着深度學習的出現,層的概念开始自動處理預處理的工作。

2.設置初始模型參數:

初始模型參數包括多個層,激活函數,初始權重,偏置,學習率等。有些可以在訓練中調整,以使用優化算法提高模型的精度。

3.訓練數據:

1)輸入被送入神經網絡,通常從一層或多層特徵提取和關系建模开始,例如卷積層(CNN)、循環層(RNN)或自注意力層。這些層學習從輸入數據中提取相關特徵,並對這些特徵之間的關系建模。

2)這些層的輸出然後通過一個或多個附加層傳遞,這些附加層對輸入數據執行不同的計算和轉換。這些層通常主要涉及與可學習權重矩陣的矩陣乘法和非线性激活函數的應用,但它們也可能包括其他操作,例如卷積神經網絡中的卷積和池化或遞歸神經網絡中的迭代。這些層的輸出作爲模型中下一層的輸入或作爲預測的最終輸出。

4.獲取模型的輸出:

神經網絡計算的輸出通常是一個向量或矩陣,表示圖像分類的概率、情感分析分數或其他結果,具體取決於網絡的應用。通常還有另一個錯誤評估和參數更新模塊,它允許根據模型的目的自動更新參數。

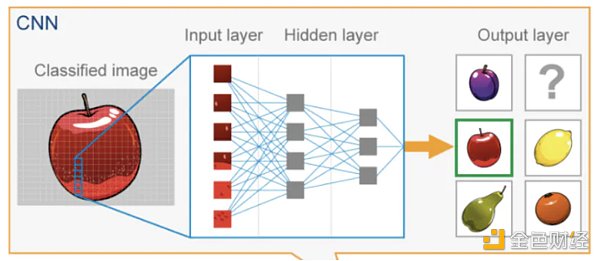

如果上面的解釋看起來太晦澀,你可以看看下面使用CNN模型識別蘋果圖像的例子。

圖像作爲像素值矩陣載入模型,這個矩陣可以被表示爲一個三維張量,其維度爲(高度、寬度、通道)。

卷積神經網絡(CNN)模型的初始參數已設定。

輸入圖像通過CNN的多個隱藏層,每一層都應用卷積濾波器從圖像中提取日益復雜的特徵。每一層的輸出通過一個非线性激活函數,然後進行池化以減少特徵映射的維度。最後一層通常是一個全連接層,根據提取的特徵產生輸出預測。

CNN的最終輸出是概率最高的類別。這就是輸入圖像的預測標籤。

機器學習信任框架

我們可以將上述內容總結爲一個機器學習信任框架,它包括四個必須可靠的機器學習層次,以使整個機器學習過程可靠:

輸入:原始數據需要被預處理,有時還需要保密。

完整性:輸入數據未被篡改,未被敵對輸入污染,並被正確預處理。

隱私:如有需要,輸入數據不會被泄露。

輸出:需要准確生成和傳輸。

完整性:正確生成輸出。

隱私:如有需要,輸出不會被泄露。

模型類型/算法:模型應該被正確計算。

完整性:模型被正確執行。

隱私:如有需要,模型本身或計算過程不會被泄露。

不同的神經網絡模型有不同的算法和層次,以滿足不同的用例和輸入。

CNN常用於處理柵格數據,如圖像,通過在小輸入區域應用卷積運算可以捕獲本地模式和特徵。

另一方面,遞歸神經網絡(RNN)適合處理順序數據,如時間序列或自然語言,其中隱藏狀態可以捕獲來自先前時間步驟的信息並建模時間依賴性。

自注意力層對捕捉輸入序列中元素之間的關系很有用,使其在需要長距離依賴的任務(如機器翻譯或總結)中非常有效。

還存在其他類型的模型,包括多層感知器(MLP)等。

模型參數:參數在某些情況下應透明或民主生成,但在所有情況下都不易被篡改。

完整性:參數以正確的方式生成、維護和管理。

隱私:模型所有者通常保密機器學習模型參數,以保護开發模型的組織的知識產權和競爭優勢。這只在Transformer模型訓練成本極高之前才普遍存在,但無論如何,這對行業來說都是一個主要問題。

第二部分:機器學習的信任問題

隨着機器學習(ML)應用的爆炸式增長(復合年增長率超過20%)以及它們在日常生活中的融合程度的增加,如ChatGPT的最近流行,對ML的信任問題變得日益重要,不能被忽視。因此,發現並解決這些信任問題對於確保AI的負責任使用和防止其潛在濫用至關重要。然而,這些問題到底是什么呢?讓我們深入了解。

缺乏透明度或可證明性

信任問題長期以來一直困擾着機器學習,主要原因有兩個:

隱私性:如前所述,模型參數通常是私有的,在某些情況下,模型輸入也需要保密,這自然會在模型擁有者和模型使用者之間帶來一些信任問題。

算法的黑匣子:機器學習模型有時被稱爲“黑匣子”,因爲它們在計算過程中涉及許多難以理解或解釋的自動化步驟。這些步驟涉及復雜的算法和大量數據,這些數據會帶來不確定的、有時是隨機的輸出,使算法成爲偏見甚至歧視的罪魁禍首。

在更深入之前,本文中更大的假設是模型已經“准備好使用”,這意味着它訓練有素並且適合目的。該模型可能不適合所有情況,並且模型以驚人的速度改進,ML 模型的正常保質期爲 2 到 18 個月不等,具體取決於應用場景。

機器學習信任問題的詳細分類

模型訓練過程存在信任問題,Gensyn 目前正在努力生成有效證據以促進這一過程。但是,本文將主要關注模型推理過程。現在讓我們使用 ML 的四個構建塊來發現潛在的信任問題:

Input:

數據源不可篡改

私人輸入數據不會被模型運營商竊取(隱私問題)

Model:

該模型本身如所宣傳的那樣准確。

計算過程正確完成。

Parameters:

模型的參數未更改或與宣傳的一樣。

模型參數對模型所有者來說是寶貴的資產,在此過程中不會泄露(隱私問題)

Output:

輸出可證明是正確的(可以通過上述所有元素進行改進)

ZK如何應用於ML信任框架

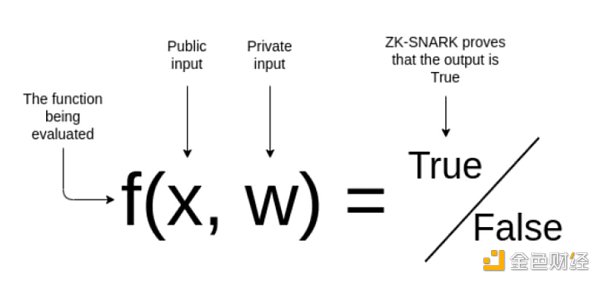

上面的一些信任問題可以通過簡單地上鏈來解決;將輸入和ML參數上傳到鏈上,模型計算上鏈,可以保證輸入、參數和模型計算的正確性。但是這種方法可能會犧牲可擴展性和隱私性。 Giza 在 Starknet 上是這樣做的,但是由於成本問題,它只支持回歸這樣簡單的機器學習模型,不支持神經網絡。 ZK 技術可以更高效地解決上述信任問題。目前ZKML的ZK通常指的是zkSNARK。首先,讓我們快速回顧一下 zkSNARKs 的一些基礎知識:

一個 zkSNARK 證明證明我知道一些祕密輸入 w 使得這個計算的結果 f 是 OUT 是真的而不告訴你 w 是什么。證明生成過程可以概括爲幾個步驟:

1.制定一個需要證明的陳述:f(x,w)=true

“我已經使用帶有私有參數 w 的 ML 模型 f 對這張圖像 x 進行了正確分類。”

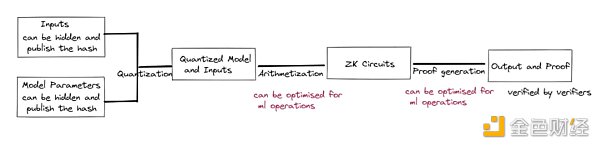

2.將語句轉換爲電路(Arithmetization):不同的電路構造方法包括R1CS、QAP、Plonkish等。

與其他用例相比,ZKML 需要一個稱爲量化的額外步驟。神經網絡推理通常在浮點運算中完成,這在運算電路的主要領域中進行仿真是極其昂貴的。不同的量化方法是精度和設備要求之間的權衡。一些電路構造方法如 R1CS 對神經網絡效率不高。可以調整這部分以提高性能。

3.生成證明密鑰和驗證密鑰

4.創建見證人:當 w=w*,f(x,w)=true

5.創建哈希承諾:見證人 w* 承諾使用加密哈希函數生成哈希值。然後可以公开此散列值。

它有助於確保私有輸入或模型參數在計算過程中未被篡改或修改。此步驟至關重要,因爲即使是微小的修改也會對模型的行爲和輸出產生重大影響。

6.生成證明:不同的證明系統使用不同的證明生成算法。

需要爲機器學習操作設計特殊的零知識規則,例如矩陣乘法和卷積層,從而爲這些計算提供具有亞线性時間的高效協議。

由於計算工作量太大,像 groth16 這樣的通用 zkSNARK 系統可能無法有效地處理神經網絡。

自 2020 年以來,出現了許多新的 ZK 證明系統來優化模型推理過程的 ZK 證明,包括 vCNN、ZEN、ZKCNN 和 pvCNN。然而,它們中的大多數都針對 CNN 模型進行了優化。它們只能應用於某些原始數據集,例如 MNIST 或 CIFAR-10。

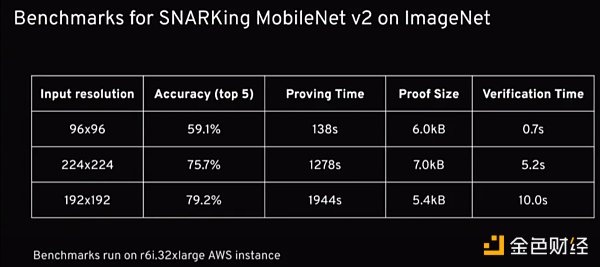

2022 年,Daniel Kang Tatsunori Hashimoto、Ion Stoica 和 Yi Sun(Axiom 創始人)提出了一種基於 Halo2 的新證明方案,首次實現了 ImageNet 數據集的 ZK 證明生成。他們的優化主要落在算術部分,具有新穎的非线性查找參數和跨層子電路的重用。

正在對鏈上推理的不同證明系統進行基准測試,發現在證明時間方面,ZKCNN 和 plonky2 表現最好;在峰值證明者內存使用方面,ZKCNN 和 halo2 表現良好;而 plonky,雖然表現不錯,但犧牲了內存消耗,ZKCNN 僅適用於 CNN 模型。它還正在开發一個新的 zkSNARK 系統,特別是針對帶有新虛擬機的 ZKML。

7.驗證證明:驗證者使用驗證密鑰進行驗證,無需見證人知曉。

因此,我們可以證明,將零知識技術應用於機器學習模型可以解決很多信任問題。使用交互式驗證的類似技術可以實現類似的結果,但將需要驗證方更多的資源,並可能面臨更多的隱私問題。值得注意的是,根據確切的模型,爲它們生成證明可能會耗費時間和資源,因此當該技術最終在實際用例中實施時,會在各個方面做出妥協。

解決方案的現狀

接下來,桌子上有什么?請記住,模型提供者可能不想生成 ZKML 證明的原因有很多。對於那些有足夠勇氣嘗試 ZKML 並且當解決方案對實施有意義時,他們可以根據他們的模型和輸入所在的位置從幾個不同的解決方案中進行選擇:

如果輸入數據在鏈上,Axiom 可以被視爲一種解決方案:

Axiom 正在爲以太坊構建一個 ZK 協處理器,以改善用戶對區塊鏈數據的訪問並提供更復雜的鏈上數據視圖。對鏈上數據進行可靠的機器學習計算是可行的:

首先,Axiom 通過將以太坊區塊哈希的 Merkle 根存儲在其智能合約 AxiomV0 中來導入鏈上數據,這些數據通過 ZK-SNARK 驗證過程進行無信任驗證。然後,AxiomV0StoragePf 合約允許根據緩存在 AxiomV0 中的塊哈希給出的信任根,批量驗證任意歷史以太坊存儲證明。

接下來,可以從導入的歷史數據中提取 ML 輸入數據。

然後 Axiom 可以在上面應用經過驗證的機器學習操作;使用優化的 halo2 作爲後端來驗證每個計算的有效性。

最後,Axiom 爲每個查詢的結果附上 zk 證明,Axiom 智能合約將驗證 zk 證明。任何想要證明的相關方都可以從智能合約中訪問它。

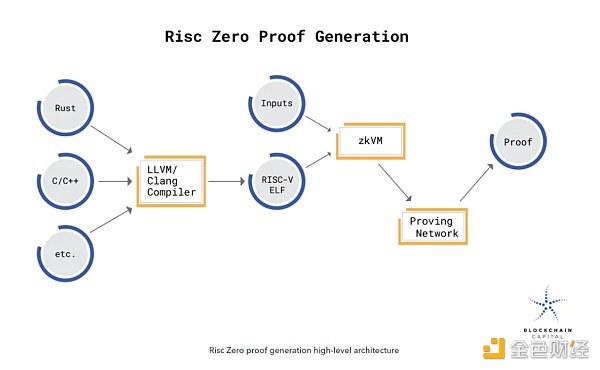

如果模型上鏈,可以考慮 RISC Zero 作爲解決方案:

RISC 零 ZKVM 是一個 RISC-V 虛擬機,它產生它執行的代碼的零知識證明。使用 ZKVM,生成加密收據,任何人都可以驗證它是由 ZKVM 的訪客代碼生成的。發布收據不會透露有關代碼執行的其他信息(例如,提供的輸入)。

通過在 RISC Zero 的 ZKVM 中運行機器學習模型,可以證明執行了模型中涉及的精確計算。計算和驗證過程可以在用戶首選環境中的鏈下完成,也可以在通用匯總的盆景網絡中完成。

首先,模型的源代碼需要編譯成 RISC-V 二進制文件。當這個二進制文件在 ZKVM 中執行時,輸出與包含加密印章的計算收據配對。該印章用作計算完整性的零知識論證,並將加密 imageID(標識已執行的 RISC-V 二進制文件)鏈接到斷言的代碼輸出,第三方可以快速驗證。

當模型在 ZKVM 中執行時,關於狀態變化的計算完全在 VM 中完成。它不會向外部各方泄露有關模型內部狀態的任何信息。

一旦模型完成執行,生成的印章將作爲計算完整性的零知識證明。

生成 ZK 證明的確切過程涉及一個以隨機預言機作爲驗證者的交互協議。 RISC 零收據上的印章本質上是此交互協議的抄本。

如果您想直接從 Tensorflow 或 Pytorch 等常用的 ML 軟件導入模型,可以考慮使用 ezkl 作爲解決方案:

Ezkl 是一個庫和命令行工具,用於對 zkSNARK 中的深度學習模型和其他計算圖進行推理。

首先,將最終模型導出爲 .onnx 文件,並將一些樣本輸入導出爲 .json 文件。

然後,將 ezkl 指向 .onnx 和 .json 文件以生成 ZK-SNARK 電路,您可以使用它來證明 ZKML 語句。

看起來很簡單,對吧? ezkl 的目標是提供一個抽象層,允許在 Halo 2 電路中調用和布置更高級別的操作。 Ezkl 抽象化了很多復雜性,同時保持了難以置信的靈活性。他們的量化模型有一個用於自動量化的比例因子。隨着新解決方案的出現,它們支持對其他證明系統進行靈活更改。它們還支持多種類型的虛擬機,包括 EVM 和 WASM。

在證明系統方面,ezkl customs halo2 circuits通過聚合證明(通過中介將難以驗證的變成容易驗證的)和遞歸(可以解決內存問題,但很難適應halo2)。 Ezkl 還使用融合和抽象優化了整個過程(可以通過高級證明減少开銷)。

另外值得注意的是,相對於其他通用的zkml項目,Accessor Labs專注於提供專爲全鏈上遊戲設計的zkml工具,可能涉及AI NPC、遊戲玩法自動更新、涉及自然語言的遊戲界面等。

第三部分:用例在哪裏?

使用 ZK 技術解決 ML 的信任問題意味着它現在可以應用於更多“高風險”和“高度確定性”的用例,而不僅僅是跟上人們的談話或區分貓的圖片和狗的圖片。 Web3 已經在探索很多這樣的用例。這並非巧合,因爲大多數 Web3 應用程序在區塊鏈上運行或打算在區塊鏈上運行,因爲區塊鏈的特定性質可以安全運行、難以篡改並具有確定性計算。一個可驗證的行爲良好的人工智能應該是一個能夠在去信任和去中心化的環境中進行活動的人工智能,對吧?

ZK+ML 有效的 Web3 用例

許多 Web3 應用程序爲了安全和去中心化而犧牲用戶體驗,因爲這顯然是他們的首要任務,並且基礎設施的限制也存在。 AI/ML 有可能豐富用戶體驗,這肯定會有所幫助,但以前似乎不可能不妥協。現在,感謝 ZK,我們可以輕松地看到 AI/ML 與 Web3 應用程序的結合,而不會在安全性和去中心化方面做出太多犧牲。

本質上,它將是一個以無信任方式實現 ML/AI 的 Web3 應用程序(在撰寫本文時可能存在也可能不存在)。通過去信任的方式,我們的意思是它是否在去信任的環境/平台中運行,或者它的操作是可證明可驗證的。請注意,並非所有 ML/AI 用例(即使在 Web3 中)都需要或首選以去信任的方式運行。我們將分析在各種 Web3 領域中使用的 ML 功能的每個部分。然後,我們會識別出需要ZKML的部分,通常是人們愿意花額外的錢來證明的高價值部分。

下面提到的大多數用例/應用程序仍處於實驗研究階段。因此,它們離實際採用還很遠。我們稍後會討論原因。

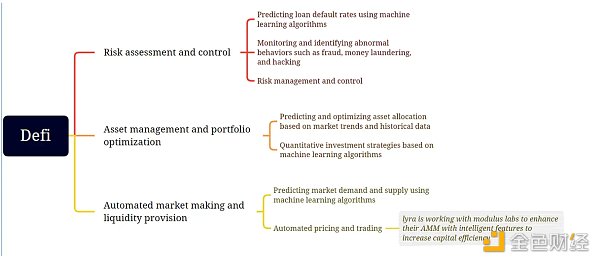

Defi

Defi 是爲數不多的適合區塊鏈協議和 Web3 應用程序的產品市場之一。能夠以無需許可的方式創造、存儲和管理財富和資本在人類歷史上是前所未有的。我們已經確定了許多 AI/ML 模型需要在未經許可的情況下運行以確保安全性和去中心化的用例。

風險評估:現代金融需要 AI/ML 模型進行各種風險評估,從防止欺詐和洗錢到發放無抵押貸款。確保這個 AI/ML 模型以可驗證的方式運行意味着我們可以防止它們被操縱進入審查制度,這阻礙了使用 Defi 產品的無許可性質。

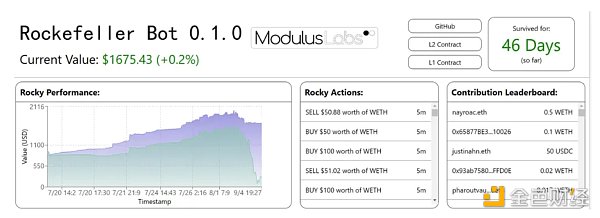

資產管理:自動交易策略對於 Tradfi 和 Defi 來說並不新鮮。已經嘗試應用 AI/ML 生成的交易策略,但只有少數去中心化策略獲得成功。目前 defi 領域的典型應用包括 Modulus Labs 試驗的 rocky bot。

The Rocky Bot :Modulus Labs 在 StarkNet 上創建了一個交易機器人,使用人工智能進行決策。

在 Uniswap 上持有資金並交換 WEth / USDC 的 L1 合約。

這適合 ML 信任框架的“輸出”部分。輸出在 L2 上生成,傳輸到 L1 並用於執行。在此過程中,它不能被篡改。

L2 合約實現了一個簡單(但靈活)的 3 層神經網絡來預測未來的 WEth 價格。該合約使用歷史 WETH 價格信息作爲輸入。

這適合“輸入”和“模型”部分。歷史價格信息輸入來自區塊鏈。模型的執行是在 CairoVM 中計算的,CairoVM 是一個 ZKVM,其執行軌跡將生成 ZK 證明以供驗證。

用於訓練回歸器和分類器的可視化和 PyTorch 代碼的簡單前端。

自動化 MM 和流動性供應:這本質上是在風險評估和資產管理方面進行的類似努力的組合,只是在涉及數量、時間表和資產類型時以不同的方式進行。關於機器學習如何用於股票市場做市的論文很多。其中一些適用於 Defi 產品可能只是時間問題。

例如,Lyra Finance 正在與 Modulus Labs 合作,通過智能功能增強他們的 AMM,以提高資本效率。

榮譽獎: Warp.cc 團隊开發了一個教程項目,介紹如何部署運行訓練有素的神經網絡以預測比特幣價格的智能合約。這屬於我們框架的“輸入”和“模型”部分,因爲輸入由 RedStone Oracles 提要提供,並且模型作爲 Arweave 上的 Warp 智能合約執行。這是第一次迭代並且涉及到 ZK,所以它屬於我們的榮譽獎,但在未來 Warp 團隊考慮實現 ZK 部分

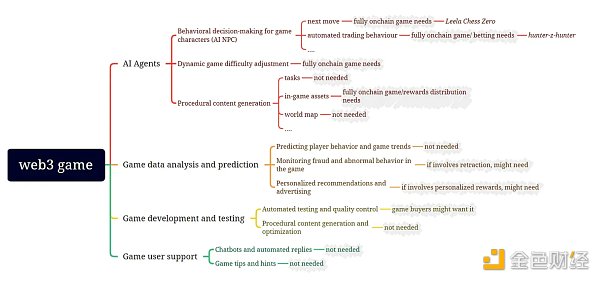

Gaming

遊戲與機器學習有很多交集:

圖中的灰色區域代表我們對遊戲部分的 ML 功能是否需要與相應的 ZKML 證明配對的初步評估。 Leela Chess Zero 是將 ZKML 應用於遊戲的一個非常有趣的示例:

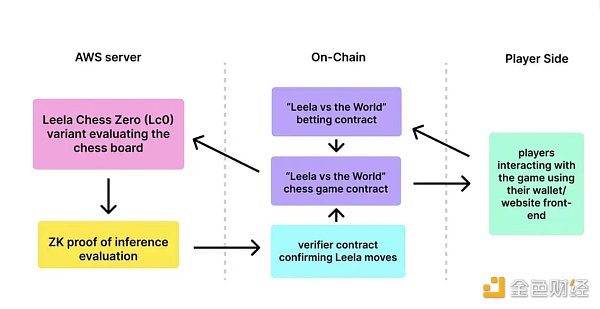

AI Agents

Leela Chess Zero (LC0):由 Modulus Labs 打造的完全鏈上人工智能國際象棋棋手,與來自社區的一群人類棋手對弈。

LC0 和人類集體輪流下棋(象棋應該如此)。

LC0 的移動是使用簡化的、電路友好的 LC0 模型計算的。

LC0 的舉動生成了 Halo2 snark 證明,以確保沒有人爲策劃幹預。只有簡化的 LC0 模型可以做出決定。

這適合“模型”部分。該模型的執行具有 ZK 證明,以驗證計算未被篡改。

數據分析和預測:這是 AI/ML 在 Web2 遊戲世界中的常見用途。然而,我們發現很少有理由將 ZK 實施到這個 ML 過程中。爲了不直接參與該過程的太多價值,可能不值得付出努力。但是,如果使用某些分析和預測來確定用戶的獎勵,則可能會實施 ZK 以確保結果正確。

榮譽獎:

AI Arena 是一款以太坊原生遊戲,全世界的玩家都可以在其中設計、訓練和战鬥由人工神經網絡驅動的 NFT 角色。來自世界各地的才華橫溢的研究人員競相創建最佳的機器學習 (ML) 模型以在遊戲中進行战鬥。 AI Arena 專注於前饋神經網絡。通常,它們的計算开銷低於卷積神經網絡 (CNN) 或遞歸神經網絡 (RNN)。不過,就目前而言,模型只有在經過訓練後才會上傳到平台,因此值得一提。

GiroGiro.AI 正在構建一個 AI 工具包,使大衆能夠創建用於個人或商業用途的人工智能。用戶可以基於直觀和自動化的 AI 工作流平台創建各種 AI 系統。只需輸入少量數據並選擇算法(或用於改進的模型),用戶就會在腦海中生成和利用 AI 模型。盡管該項目處於非常早期的階段,但由於 GiroGiro 專注於 gamefi 和以虛擬世界爲重點的產品,因此我們非常期待看到它能帶來什么,因此它獲得了榮譽獎。

DID 和社交

在DID&social領域,web3和ml的交集目前主要在proof of humanity和proof of credentials領域;其他部分可能會發展,但需要更長的時間。

人性的證明

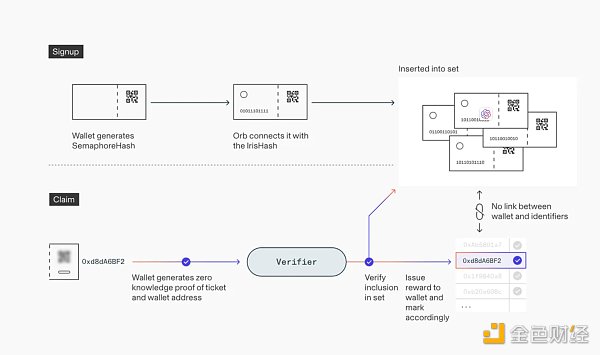

Worldcoin 使用一種稱爲 Orb 的設備來確定某人是否是一個沒有試圖欺騙驗證的真實存在的人。它通過各種相機傳感器和分析面部和虹膜特徵的機器學習模型來實現這一點。一旦做出決定,Orb 就會拍攝一組人的虹膜照片,並使用多種機器學習模型和其他計算機視覺技術來創建虹膜代碼,這是個人虹膜圖案最重要特徵的數字表示。具體報名步驟如下:

用戶在她的手機上生成一個信號量密鑰對,並將散列的公鑰(通過二維碼)提供給 Orb。

Orb 掃描用戶的虹膜並在本地計算用戶的 IrisHash。然後,它將包含散列公鑰和 IrisHash 的籤名消息發送到注冊定序器節點。

定序器節點驗證 Orb 的籤名,然後檢查 IrisHash 是否與數據庫中已有的不匹配。如果唯一性檢查通過,則保存 IrisHash 和公鑰。

Worldcoin 使用开源的 Semaphore 零知識證明系統將 IrisHashes 的唯一性轉移到用戶帳戶的唯一性,而無需將它們鏈接起來。這確保了新注冊的用戶可以成功領取他/她的 WorldCoins。步驟如下:

用戶的應用程序在本地生成一個錢包地址。

該應用程序使用信號量來證明它擁有先前注冊的一個公鑰的私有副本。因爲它是零知識證明,所以它不會透露哪個公鑰。

證明再次發送到排序器,排序器對其進行驗證並啓動將代幣存入提供的錢包地址。一個所謂的無效符與證明一起發送,並確保用戶不能兩次要求獎勵。

WorldCoin 使用 ZK 技術確保其 ML 模型的輸出不會泄露用戶的個人數據,因爲它們不會相互關聯。在這種情況下,它屬於我們信任框架的“輸出”部分,因爲它確保輸出以所需方式傳輸和使用,在這種情況下是私密的。

行動證明

Astraly 是一個建立在 StarkNet 上的基於聲譽的代幣分發平台,用於尋找和支持最新最好的 StarkNet 項目。衡量聲譽是一項具有挑战性的任務,因爲它是一個抽象概念,無法用簡單的指標輕松量化。在處理復雜的指標時,通常情況下,更全面和多樣化的輸入會產生更好的結果。這就是爲什么 Astraly 正在尋求 modulus labs 的幫助,以使用 ML 模型來提供更准確的聲譽評級。

個性化推薦和內容過濾

Twitter 最近爲“爲你”時間线开源了他們的算法,但用戶無法驗證該算法是否正確運行,因爲用於對推文進行排名的 ML 模型的權重是保密的。這導致了對偏見和審查制度的擔憂。

然而,Daniel Kang、Edward Gan、Ion Stoica 和 Yi Sun 提供了一種解決方案,使用 ezkl 提供證據證明 Twitter 算法在不泄露模型權重的情況下誠實運行,從而幫助平衡隱私和透明度。通過使用 ZKML 框架,Twitter 可以提交其排名模型的特定版本,並發布證據證明它爲給定用戶和推文生成了特定的最終輸出排名。該解決方案使用戶能夠驗證計算是否正確執行,而無需信任系統。雖然要使 ZKML 更加實用還有很多工作要做,但這是提高社交媒體透明度的積極步驟。因此,這屬於我們的 ML 信任框架的“模型”部分。

從用例角度重新審視 ML 信任框架

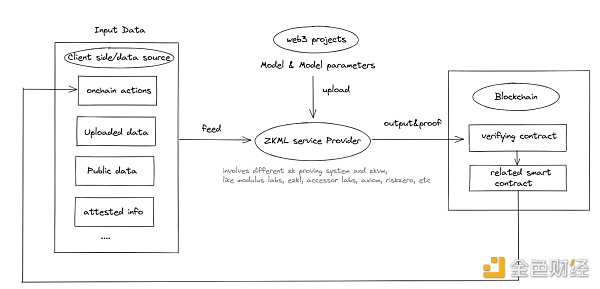

可以看出,ZKML 在 web3 中的潛在用例仍處於起步階段,但不容忽視;未來隨着ZKML的使用範圍不斷擴大,可能會出現對ZKML提供者的需求,形成下圖的閉環:

ZKML 服務提供商主要關注 ML 信任框架的“模型”和“參數”部分。盡管我們現在看到的大多數與“模型”相關而不是“參數”。請注意,“輸入”和“輸出”部分更多地由基於區塊鏈的解決方案解決,用作數據源或數據目的地。單獨的 ZK 或區塊鏈可能無法實現完全可信,但它們聯合起來可能會做到。

離大規模採用還有多遠?

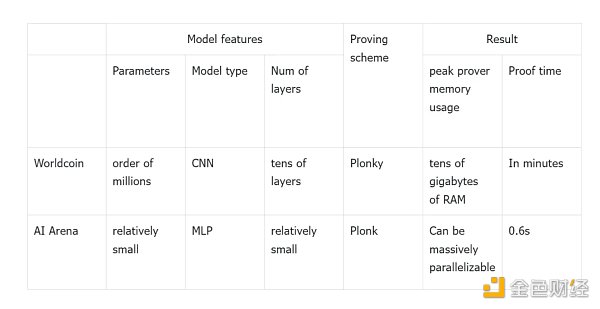

Modulus Labs 的論文通過測試 Worldcoin(具有嚴格的精度和內存要求)和 AI Arena(具有成本效益和時間要求),爲我們提供了一些關於 ZKML 應用可行性的數據和見解:

如果 Worldcon 使用 ZKML,證明者的內存消耗將超過任何商用移動硬件。如果 AI Arena 的錦標賽使用 ZKML,則使用 ZKCNN 會將時間和成本增加到 100 倍(0.6 秒對原來的 0.008 秒)。所以遺憾的是,直接應用 ZKML 技術來證明時間和證明內存使用都是不可行的。

證明大小和驗證時間如何?我們可以參考 Daniel Kang 、 Tatsunori Hashimoto 、 Ion Stoica 和 Yi Sun 的論文。如下圖所示,他們的 DNN 推理解決方案可以在 ImageNet(模型類型:DCNN,16 層,340 萬個參數)上實現高達 79% 的准確率,同時只需 10 秒和 5952 字節的驗證時間。此外,zkSNARKs 可以縮小到只需 0.7 秒即可以 59% 的准確率進行驗證。這些結果表明 zkSNARKing ImageNet 規模模型在證明大小和驗證時間方面的可行性。

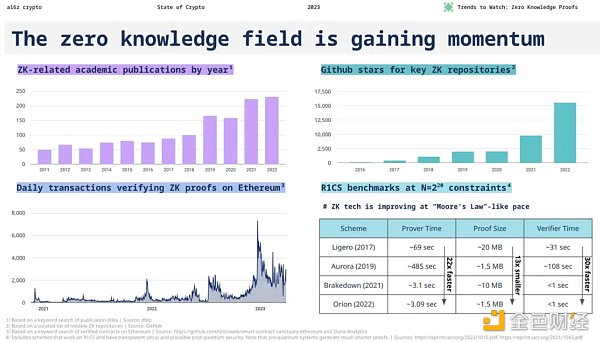

現在主要的技術瓶頸在於時間和內存消耗的證明。在 web3 案例中應用 ZKML 在技術上仍然不可行。 ZKML 能否抓住 AI 的發展潛力?我們可以對比幾個經驗數據:

ML模型的發展速度:2019年發布的GPT-1模型有1.5億個參數,而2020年最新發布的GPT-3模型有1750億個參數,參數數量在短短兩年內增長了1166倍.

ZK系統的優化速度:ZK系統的性能增長基本遵循“摩爾定律”式的步伐。幾乎每年都會推出新的 ZK 系統,我們預計證明者性能的火箭式增長將持續一段時間。

比較前沿的ML對ZK的提升幅度,前景不是很樂觀。然而,隨着rollup性能、ZK硬件以及基於高度結構化神經網絡操作的量身定制的ZK證明系統的不斷改進,希望ZKML的开發能夠滿足web3的需求,並從提供一些老式的機器學習功能开始第一的。

盡管我們可能很難使用區塊鏈 + ZK 來驗證 ChatGPT 提供給我的信息是否值得信賴,但我們或許能夠將一些更小和更舊的 ML 模型放入 ZK 電路中。

第四部分:結論

“權力導致腐敗,絕對的權力導致絕對的腐敗”。憑借 AI 和 ML 令人難以置信的力量,目前還沒有萬無一失的方法將其置於治理之下。政府一再證明可以爲後果提供後期幹預或早期徹底禁止。區塊鏈 + ZK 提供了能夠以可證明和可驗證的方式馴服野獸的少數解決方案之一。

我們期待在 ZKML 領域看到更多的產品創新,ZK 和區塊鏈爲 AI/ML 的運行提供安全可信的環境。我們還期望全新的商業模式會從這些產品創新中產生,因爲在無需許可的加密世界中,我們不受這裏首選的 SaaS 商業化模式的限制。我們期待支持更多的建設者前來,在這個“狂野西部無政府狀態”和“象牙塔精英”的迷人重疊中構建他們激動人心的想法。

我們還早,但我們可能會在路上拯救世界。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。