來源:InfoQ

北京時間凌晨 4:00,大洋彼岸的美國加利福尼亞州聖何塞的聖何塞會議中心,被稱爲英偉達技術盛宴的 GTC 2024 大會正如火如荼地進行着。作爲英偉達 2024 的开年大戲,身着標志性皮夾克的萬億富豪黃教主站在舞台中央,平靜地甩出繼 H100、A100 後的又一系列“核彈”級超級芯片。

今年的 GTC 之所以萬衆矚目,是因爲過去一年英偉達在 AI 領域的財務業績方面取得了巨大成功。從 Volta V100 GPU 系列到最新的 Ampere A100 和 Hopper H100 芯片,該公司一直問鼎 AI 芯片之王。

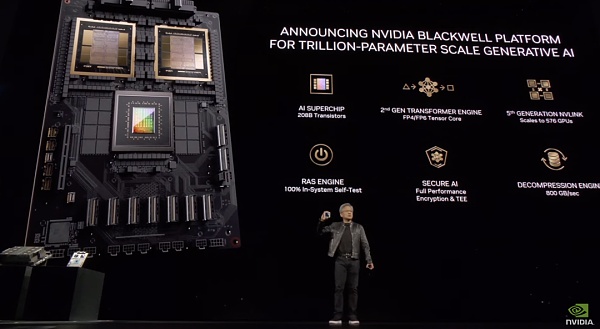

1.GPU 家族再添“新丁”,全新 Blackwell 架構芯片炸場

在本屆 GTC 大會开始之前,國外媒體就已經开始盛傳:黃仁勳將在 GTC 2024 上發布一款 GPU 家族的新品,果然,採用 Blackwell 架構的 B200 和 GB200 系列芯片如期而至。

據英偉達稱,Blackwell 架構系列芯片是迄今爲止功能最強大的 AI 芯片家族。

據老黃介紹,B200 擁有 2080 億個晶體管(而 H100/H200 上有 800 億個晶體管),採用台積電 4NP 工藝制程,可以支持多達 10 萬億個參數的 AI 模型,而 OpenAI 的 GPT-3 由 1750 億個參數組成。它還通過單個 GPU 提供 20 petaflops 的 AI 性能——單個 H100 最多可提供 4 petaflops 的 AI 計算。

但值得注意的是,Blackwell B200 並不是傳統意義上的單一 GPU。它由兩個緊密耦合的芯片組成,這兩個芯片通過 10 TB/s NV-HBI(Nvidia 高帶寬接口)連接進行連接,以確保它們能夠作爲單個完全一致的芯片正常運行。

該 GPU 平台以數學家 David Harold Blackwell 的名字命名,繼承了英偉達兩年前推出的 Hopper 架構,基於該架構一系列產品使英偉達的業務及其股價飆升。

該架構在 AI 安全方面又向前邁進了重要一步。Blackwell 通過 100% 系統內自測試 RAS 服務和全性能加密提供安全的 AI,也就是說數據不僅在傳輸過程中安全,而且在靜止狀態和計算時也安全。

Blackwell 將被整合到英偉達的 GB200 Grace Blackwell 超級芯片中,該芯片將兩個 B200 Blackwell GPU 連接到一個 Grace CPU。英偉達沒有透露價格。

新芯片預計將於今年晚些時候上市。英偉達表示,AWS、戴爾科技、谷歌、Meta、微軟、OpenAI 和特斯拉計劃使用 Blackwell GPU。

“生成式人工智能是我們這個時代的決定性技術,”老黃在演講時表示。“Blackwell GPU 是推動這場新工業革命的引擎。與世界上最具活力的公司合作,我們將實現人工智能對每個行業的承諾。”

英偉達還發布了 GB200 NVL72 液冷機架系統,其中包含 36 顆 GB200 Grace Blackwell 超級芯片,擁有 1440 petaflops(又名 1.4 exaflops)的推理能力,它內部有近兩英裏長的電纜,共有 5000 根單獨的電纜。

英偉達表示,與用於推理用途的相同數量的 H100 Tensor Core 圖形處理單元相比,GB200 NVL72 性能提升高達 30 倍。此外,該系統還可將成本和能耗降低多達 25 倍。

GB200 NVL72

例如,訓練一個 1.8 萬億參數模型之前需要 8000 個 Hopper GPU 和 15 兆瓦的功率。如今,只需要 2000 個 Blackwell GPU 就可以做到這一點,而功耗僅爲 4 兆瓦。

在具有 1750 億個參數的 GPT-3 基准測試中,英偉達表示 GB200 的性能是 H100 的 7 倍,訓練速度是 H100 的 4 倍。

此外,英偉達稱還將推出一款名爲 HGX B200 的服務器主板,它基於在單個服務器節點中使用 8 個 B200 GPU 和一個 x86 CPU(可能是兩個 CPU)。每個 B200 GPU 可配置高達 1000W,並且 GPU 提供高達 18 petaflops 的 FP4 吞吐量,因此比 GB200 中的 GPU 慢 10%。

目前,企業客戶可以通過 HGX B200 和 GB200(將 B200 GPU 與 英偉達的 Grace CPU 結合在一起)訪問 B200。

2.全面升級軟件服務

市場正在升溫,硬件和軟件方面的競爭都在加劇。在本次 GTC 中,英偉達不僅通過新的硬件創新來應對競爭,還展示了其 AI 軟件战略如何幫助確定其在該領域的領導地位,以及未來幾年將如何發展。

黃仁勳還着力推銷其 AI 軟件訂閱服務包,這顯然是在配合該公司向“以軟件賣硬件”的新战略,也是在與過往的“以硬件賣軟件”的战略徹底告別。

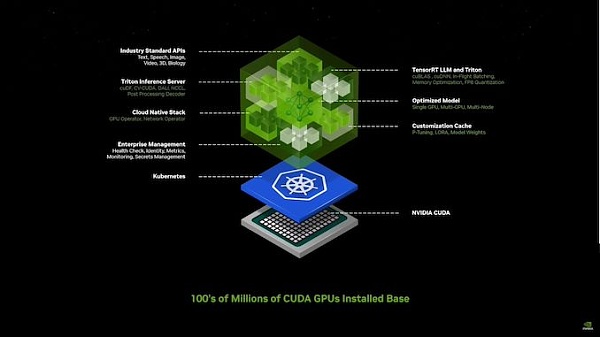

英偉達可以訪問所有領域的大量模型,但他們認爲對於企業來說它們仍然太難使用。他們推出了 Nvidia 推理微服務(NIM),將模型和依賴項整合到一個簡潔的包中,根據用戶的堆棧進行優化,並與易於使用的 API 連接。

經過打包和優化的預訓練模型,可在 NVIDIA 的安裝基礎上運行,包含運行它所需的所有軟件。CUDA 庫、API 等,基本上是容器化的 AI 軟件包,針對 NV GPU 進行了優化,並帶有一個簡單的 API 來訪問它們。

老黃指出:“這就是我們未來編寫軟件的方式”——通過組裝一堆人工智能。

老黃我們介紹了英偉達如何使用 英偉達推理微服務(NIM)創建一個內部聊天機器人,旨在解決構建芯片時遇到的常見問題。“我們需要一個模擬引擎,以數字方式爲機器人呈現世界,”他說,這就是 Omniverse。這些“微服務”將允許开發人員使用專有和自定義模型快速創建和部署“副駕駛”或人工智能助手。

他表示,機器人技術與人工智能和 Ominverse/Digital Twin 工作一起成爲英偉達的關鍵支柱,所有這些都共同努力以充分利用公司的系統。

據悉,Omniverse 是一個專爲構建和操作 Metaverse 應用程序而設計的平台,本質上是人們可以交互、工作和創建的共享虛擬世界。Omniverse 平台可以創建數字孿生和高級模擬。英偉達對 Omniverse 的愿景包括成爲 Metaverse 的基礎平台,創作者和企業可以在共享虛擬空間中進行協作。在 Omniverse 中創建的數字孿生可用於 Metaverse 中的各種應用,例如虛擬培訓、產品設計和預測性維護。

老黃表示英偉達已經推出了數十種企業級生成式 AI 微服務,企業可以使用這些服務在自己的平台上制作應用程序,同時保留對其知識產權的完全所有權和控制權。

老黃還宣布將 Omniverse Cloud 流傳輸至 Apple Vision Pro 耳機。

他也表示,英偉達表示正認真考慮從根本上重新設計整個底層軟件堆棧,希望借 AI 之力爲人類生成更優質的代碼。

之所以會有這樣的想法,原因非常簡單:幾十年來,整個世界一直受制於圍繞 CPU 發展出的傳統計算框架,即由人類編寫應用程序以檢索數據庫中准備好的信息。

黃仁勳在發布會上指出,“我們今天的計算方式,首先需要確定信息是由誰編寫、由誰創建的,也就是要求信息先要被記錄下來。”

而英偉達的 GPU 爲加速計算开闢出一條通往算法化計算的新路,可以依托創造性推理(而非固有邏輯)來確定相關結果。

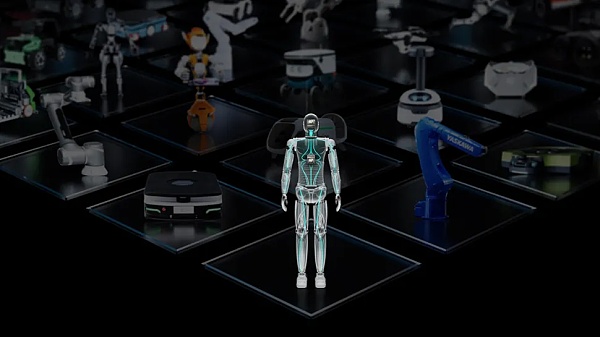

此外,英偉達希望通過發布另一個新的 API 集合 Project GROOT 來推動人形機器人的开發。

Project GROOT 是一個人形機器人模型,英偉達與 Jetson Thor 一起生產,Jetson Thor 是一款 SoC,也是 Nvidia Isaac 的升級版。英偉達表示,GROOT 機器人將理解自然語言並模仿人類動作來學習靈活性。Jetson Thor 運行基於 Blackwell 的 GPU,可在 8 位數據處理中提供 800 teraflops 的 AI 性能。

老黃透露,由該平台驅動的機器人將被設計爲能夠理解自然語言並模仿機器人的動作,觀察人類行爲。這使 GROOT 機器人能夠快速學習協調性、靈活性和其他技能,以導航、適應現實世界並與之互動——並且絕對不會導致機器人叛亂。

“爲通用人形機器人構建基本模型是我們當今人工智能領域能夠解決的最令人興奮的問題之一,”老黃說。“這些使能技術正在融合在一起,使世界各地領先的機器人專家能夠在人工通用機器人領域取得巨大飛躍。”

3.對开發者的影響

根據專家預測,五年之後,文本、圖像、視頻和語音等形式的信息將全部被實時輸入大語言模型(LLM)。屆時計算機將直通所有信息源,通過多模態交互不斷實現自我改進。

黃仁勳表示,“未來,我們將步入持續學習的時代。我們可以決定是否部署持續學習的成果,而且與計算機的交互不會再借助 C++。”

這就是 AI 技術的意義所在——人類可以在推理之後,要求計算機生成代碼以實現特定目標。換句話說,未來人們可以用簡單的語言、而非 C++ 或者 Python,與計算機實現順暢交流。

“在我看來,編程本身的價值正在悄然跨過歷史性的衰退拐點。”黃仁勳還補充稱,AI 已經在彌合人類與技術之間的鴻溝。

“就在當下,約有上千萬人憑借自己的計算機編程知識來謀取職位、賺得收益,而余下的 80 億人則被他們遠遠甩在身後。未來的情況將有所改變。”

在黃仁勳看來,英語將成爲最強大的編程語言,而個性化交互則是縮小技術鴻溝的關鍵因素。

生成式 AI 將成爲一種宏觀層面的操作系統,人類可以在其中用簡單的語言指示計算機創建應用程序。黃仁勳表示,大語言模型將幫助人類通過計算機把自己的靈感轉化爲現實。

例如,人類已經可以要求大語言爲特定領域的應用程序生成 Python 代碼,且全部提示內容均使用簡單英語編寫而成。

“我們要如何讓計算機按自己的想法做事?我們要如何在計算機上實現指令微調?這些問題的答案就是提示詞工程,而且更多是種藝術、而非單純的技術。”

也就是說人類將可以專注於領域專業知識,而生成式 AI 將補齊編程技能這塊短板。黃仁勳認爲這將徹底顛覆軟件的开發格局。

黃仁勳此前曾將大語言模型比作經過預培訓且頭腦靈光的大學畢業生。英偉達正圍繞大模型提供醫療保健與金融等領域的專業知識,借此爲企業客戶提供高效支持。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。