【導讀】《頭號玩家》的世界近在咫尺!周末,小扎在元宇宙开啓了1小時「真人對談」,讓主播感慨差點忘記眼前的人竟不是真人。

起猛了!

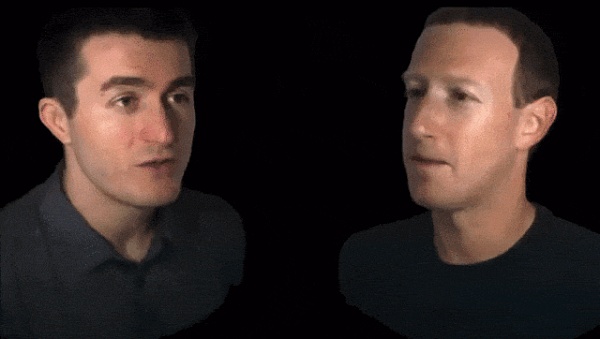

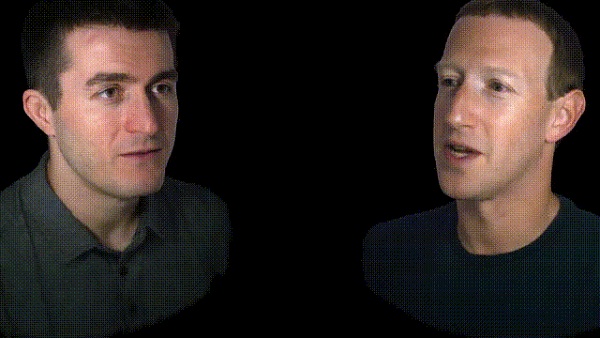

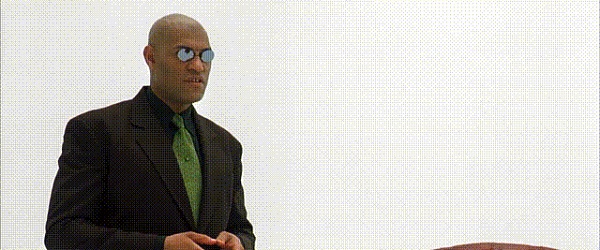

就在昨天,美國知名播客主播Lex Fridman與小扎开啓了1個小時的元宇宙「面對面」聊天,震驚了全世界。

Lex Fridman聊着聊着,直言「我差點忘記,眼前的你不是真人」。

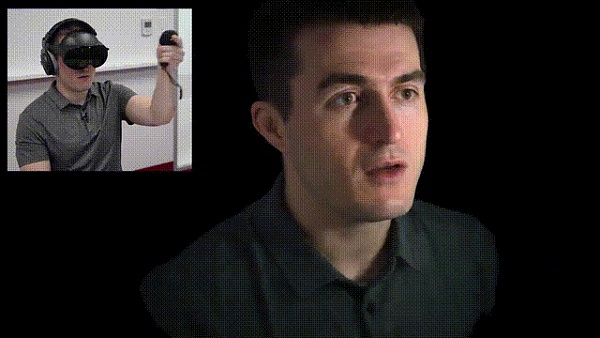

他們戴上Meta的頭顯,相隔數百公裏,卻能如此逼真還原Aavtar的面部表情和動作。

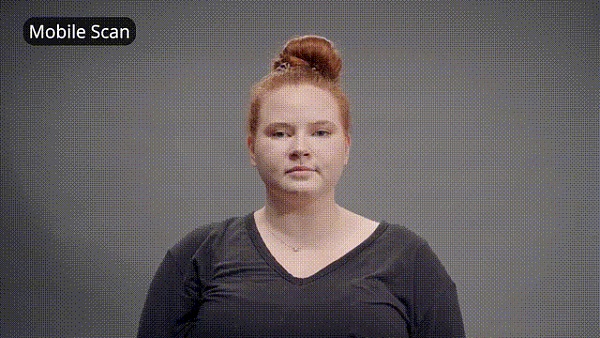

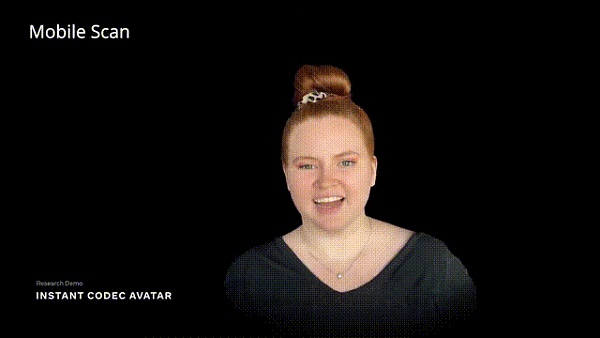

而這背後,是19年Meta提出的一個輕松創建虛擬人化身的技術Codec Avatars,只需要一部手機,就能捕捉人類細微的表情差異。

有網友表示,別說人家聊的身臨其境,就連自己看的太投入,9分鐘的時候,恍然間覺得他們就是真人在對話!

甚至讓前谷歌科學家David Ha改變了對「元宇宙」懷疑的態度。

大約13個月的時間,小扎對於元宇宙的「真愛」似乎开始要有回報了。

從2021年到現在,Meta元宇宙實驗室投入數百億美元都賠了本,但是也終讓人們看到了「頭號玩家」裏的世界離我們更近一步。

接下來,一起看看小扎和Lex虛擬化身對談的精彩瞬間吧。

訪談實錄

一出場,Fridman和小扎的訪談就在元宇宙中开始了。

雖然一個人在加州,一個人在德州奧斯丁,通過Codec Avatar和3D立體聲技術,兩個人就像直接面對面坐在一起一樣,开始了這場可能會載入史冊的會面和聊天。

Fridman調整了一下光源的位置,兩個人都明顯感到了光线的變化。

而兩個人周圍的其他的地方,都是漆黑一片。

看着對方清晰的臉和生動的表情,真的覺得這一切就發生在了一個關了燈的房間裏。

而Fridman最直觀的感受是,這一切實在是太真實了,真實得讓人有點接受不了。

在這樣的一個環境之下,長達一個小時的訪談开始了。

訪談涉及了小扎對於元宇宙的暢想,以及什么是「真實」的討論,而最令大家關注的,應該還是小扎對於AI和元宇宙結合前景的看法,以及他對Meta AI未來的計劃。

三年全身模擬就來

在小扎看來,未來 AI 技術將會在元宇宙中扮演非常重要的角色。

未來肯定會有非常強大的超級人工智能,但是依然會有很多AI工具能讓人們非常方便的完成各種各樣的任務。

他以Fridman的播客節目舉例,播客主播需要盡可能的保持和自己的社區觀衆的互動。但是主播不可能 24 小時不休息地來做這個事。

如果能夠在元宇宙中建立一個AI來幫助主播來維持自己粉絲社區的活力,滿足粉絲們提出的各種要求,將會讓主播能完成以前可能完全沒有辦法完成的事情。

而且Meta希望這樣的AI不僅僅是出現在元宇宙中,而是在現在已經有的各種平台上,來幫主播、

網紅們維護自己的粉絲、用戶社區。

Meta未來會盡快發布這個功能,賦能更多的內容創作者。

進一步地,Meta AI會更多地出現在元宇宙的各個地方,和用戶進行交流,爲用戶提供幫助。

不同的AI角色在元宇宙中會以不同的性格展現出來,爲用戶提供非常豐富多樣的體驗。

而現在這些不同角色的AI已經處於最後的准備階段了。Meta希望能讓這些AI更加可預測,保障安全性。

除了讓普通用戶在元宇宙中的體驗更好,AI可以在元宇宙中爲企業,或者代表企業向客戶提供各種各樣嚴肅專業的服務。

在元宇宙的遊戲中,AI能讓NPC表現得更加吸引人。他們一個正在开發的類似劇本殺的史努比遊戲,AI作爲遊戲的主持人表現非常好,非常搞笑,很有意思。

Llama 3在路上

Fridman繼續問了小扎關於Meta AI目前的一些情況,關於Llama 2和未來的Llama 3,小扎也知無不言,不斷爆料。

在上一次和Fridman的播客中,小扎和他討論了關於是否开源Llama 2,小扎很高興Meta最終這么做了。

在小扎看來,現在开源一個Llama 2這樣的基礎模型的價值,遠遠大於風險。

小扎說在开源之前,Meta花了很多時間,進行了非常嚴格的評估和紅隊模擬,最終才开源了它。Llama 2的下載和使用量比小扎預期的還要多。

Llama 3呢,肯定會有的。不過在开源Llama 2後,現在Meta的優先事項是將其集成到各種消費者產品中。

因爲Llama 2本身並不是一個消費者產品。它更像是一個基礎設施,人們可以用它來構建東西。所以,現在的重點是繼續微調,並且,就是讓Llama 2及以及各個版本能夠服務好消費者產品。

希望有一天數以億計的人會喜歡使用這些產品。

但是,Meta也在致力於开發未來的基礎模型。現在沒有太多能透露的,不過肯定也會像Llama 2一樣,經歷嚴格的紅隊測試才會公布。

小扎也希望,當Llama 3成型時,Meta會繼續开源。但是,這個事Meta還沒有最終確定下來,因爲現在離Meta發布下一代基礎模型還比較遙遠。

不過开源模型能夠讓人們更好地體驗模型能做什么事情,比如小扎本人就很沉迷於和各種各樣的AI虛擬角色聊天,非常上頭。

人類未來生活

對於未來人類的生活,小扎說,元宇宙會無處不在!

最簡單的例子就是電話,未來人類會像現在打電話一樣,體驗到自己和虛擬世界的真實互動。

比如兩個人可以隨時隨地體驗他們兩現在的交流方式,除了兩個沒有真的坐在一間屋子裏,其他方面這樣的交流會和面對面的交流沒有任何區別。

因爲從哲學的角度來看,真實世界的本質就是我們能夠感知到的東西和實際存在的東西的結合。

數字世界如果能夠越來越好的還原這個方面,數字世界就能變得越來越豐富和強大。

最後,Fridman問小扎,你該不會是坐在沙灘上和我聊的吧。

小扎說,沒有,我坐在會議室裏。

Fridman說,可惜了,我就坐在沙灘上,而且我褲子都沒穿,幸好你們沒看到我真實的樣子。

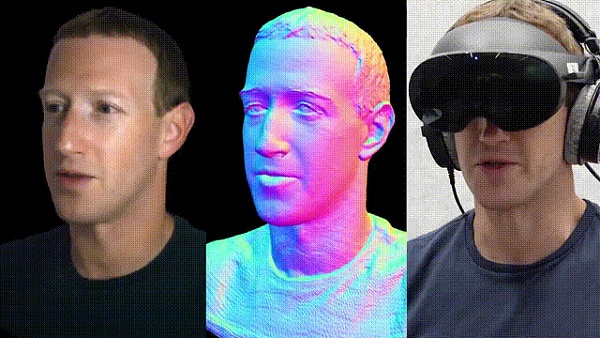

Codec Avatars:一部手機,化身就來

其實,我們看到博客視頻中,如此驚豔的技術,其實Meta早在19年就研發出來了。

它就是——Codec Avatars。

若想在元宇宙中實現真正的交互,虛擬化身可是打开元宇宙這道門的任督二脈。

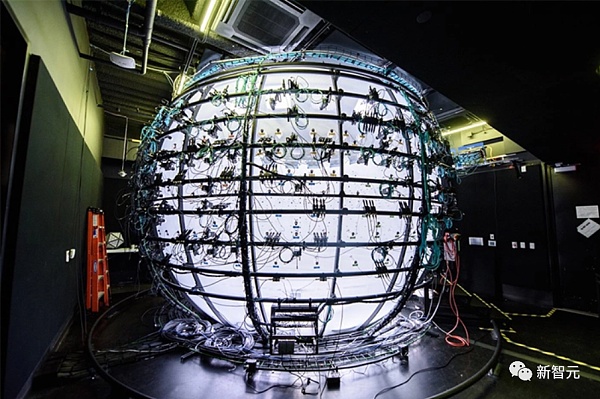

Codec Avatars這一項目旨在實現一個能夠捕獲和表示用於XR的逼真頭像的系統。

最初這個項目是以高質量的頭像演示开始,後來逐漸實現構建全身的虛擬化身。

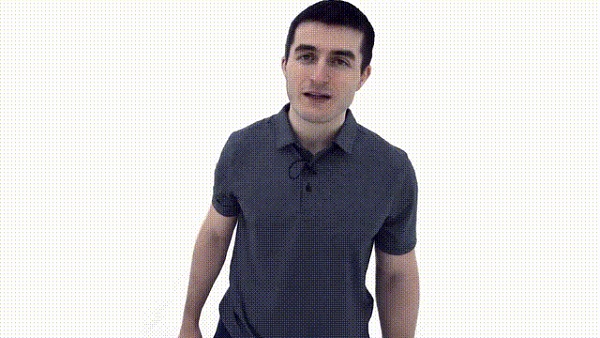

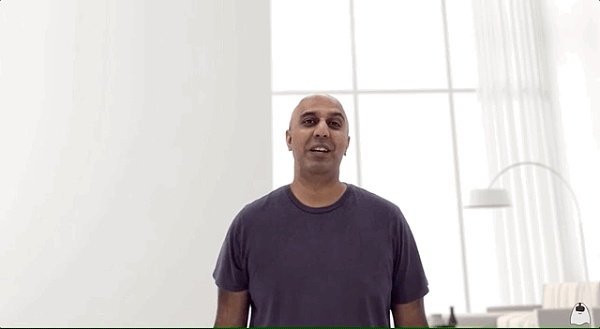

在Connect 2021大會上,研究人員Yaser Sheikh曾展示了該團隊最新的成果——全身視頻編解碼器(Full-body Codec Avatars)。

與此同時,Codec Avatars支持更復雜的眼部運動、面部表情、手部和身體姿勢。

此外,Meta還展示了虛擬化身在對不同的光照條件和環境下實現頭發和皮膚的真實渲染。

Meta开始制作Codec Avatars的契機要追溯到9年前。

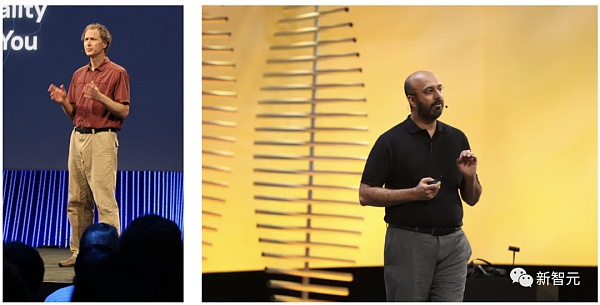

2014年,卡內基梅隆大學機器人研究所旗下的一家3D捕捉實驗室Panoptic Studio的負責人Yaser Sheikh遇到了Oculus首席科學家Michael Abrash,兩人聊得非常投機。

左:Michael Abrash;右:Yaser Sheikh

2015年,Yaser Sheikh加入了Meta,從那以後便一直領導着Codec Avatars研究團隊。

「要想打造一個逼真的化身,基礎在於測量」,Codec Avatars研究科學家托馬斯·西蒙說。

「化身要以假亂真靠的是精確的數據,這需要良好的測量。因此,構建真實化身的關鍵是找到一種方法來測量人類表情中的物理細節,比如一個人眯起眼睛或皺起鼻子的方式。」

在匹茲堡實驗室的Codec Avatars團隊,使用了兩個主要的模塊來測量人類的表情:編碼器和解碼器。

而現在,人們只需要一部手機,就能精確捕捉到面部表情的信息。

直接在元宇宙中還原真身。

網友驚呼:恐怖谷

看過這期博客的網友們,紛紛被視頻中的效果驚豔。

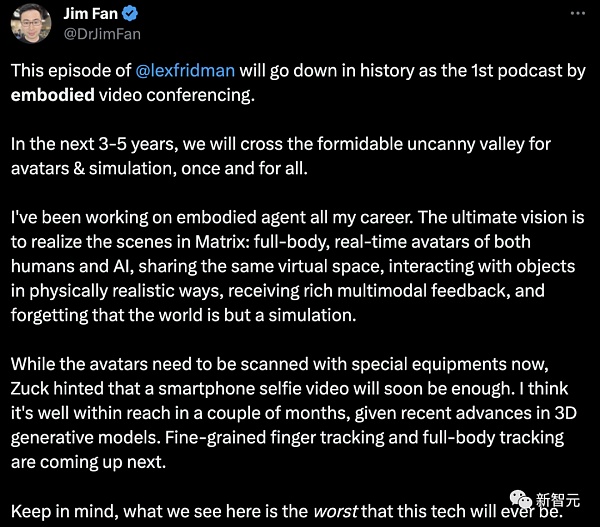

英偉達高級科學家Jim Fan表示,

本期 @lexfridman 將作爲第一個由虛擬化身的視頻會議制作的播客載入史冊。

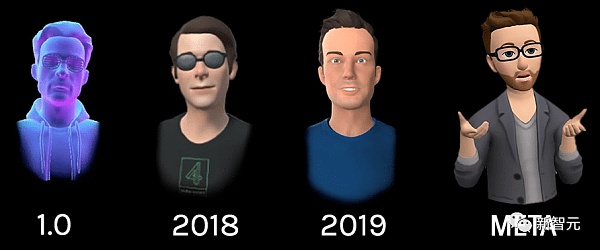

在未來3-5年內,我們將徹底跨越Avatar和模擬的「恐怖谷」。

在我的職業生涯中,我一直在研究化身智能體。我們的終極愿景是實現《黑客帝國》中的場景:人類和人工智能的全身實時化身,共享同一個虛擬空間,以逼真的方式與物體互動,接收豐富的多模態反饋,忘記世界只是一個模擬。

雖然化身現在需要用特殊設備進行掃描,但扎克暗示,智能手機自拍視頻很快就能實現。

鑑於3D生成模型的最新進展,我認爲幾個月內就能實現。細粒度手指追蹤和全身追蹤將是下一個目標。

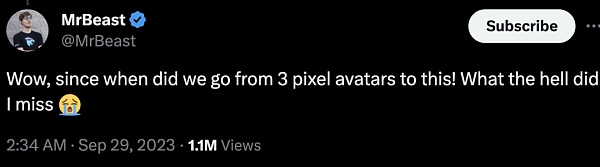

從3個像素的頭像怎么一下就進化到這個了?一定是我起猛了!

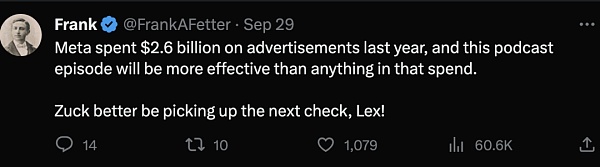

去年Meta在廣告和市場營銷上花了26億美元,這個播客的效果比這些錢效果好多了,Lex趕快讓小扎給你打錢!

雖然眼球追蹤還有些小錯誤,但是表情的精准呈現讓人忘了這其實只是虛擬化身。未來已來!

怪不得馬斯克找不到小扎,原來小扎躲到這裏了!

最後,訪談原視頻放在這裏了。

參考資料:

https://twitter.com/lexfridman/status/1707453830344868204

https://twitter.com/bilawalsidhu/status/1708152584152768822

https://twitter.com/DrJimFan/status/1707796272453910930

https://twitter.com/packyM/status/1707572280018993252

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。